Solutions de vision embarquées en tant que capteurs intelligents pour les applications IoT

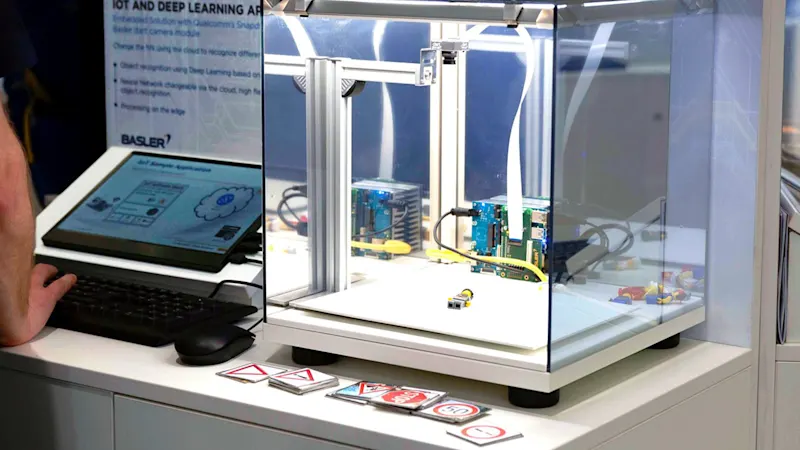

Notre démo en direct montre comment une solution de vision embarquée peut être utilisée comme capteur efficace et intelligent pour la classification des données d’image. En savoir plus à ce sujet.

Comment fonctionnent les applications IoT intelligentes

Les capteurs IoT, tels qu’une caméra, ne sont généralement connectés au cloud qu’avec une très faible bande passante. Par conséquent, la transmission de la grande quantité de données d’image serait lente. Une solution consiste à effectuer l’analyse des données d’image à l’emplacement du capteur de la caméra lui-même, "en périphérie" (traitement en périphérie), puis à transférer uniquement les données évaluées vers le cloud. Une connexion avec une très faible bande passante est tout à fait suffisante à cet effet. Ainsi, le transfert vers le cloud peut être effectué très rapidement et la caméra peut réagir à un incident.

En savoir plus sur nos solutions de vision embarquéeÉtape 1 : Trouver le bon matériel pour le système de vision embarqué

Cette démo en direct est basée sur le kit primé Basler Embedded Vision. Ce kit se compose de

un dart BCON pour module de caméra MIPI de Basler

une carte de traitement compatible 96 cartes™ avec SoC Qualcomm® Snapdragon™ et

une carte mezzanine compatible 96 Boards™ pour connecter directement le module caméra à la carte de traitement

Cette solution permet de traiter les données d’image capturées par le module de caméra à des fréquences d’images élevées directement sur la carte de traitement.

Découvrir le portefeuille Embedded VisionÉtape 2 : Entraîner les réseaux neuronaux pour la classification

Le but de la démo en direct est de pouvoir classer différentes figurines Lego (artisan, astronaute, cuisinier, etc.) ou différents panneaux de signalisation. Cette tâche est effectuée par les réseaux de neurones, plus précisément par les réseaux de neurones convolutifs (CNN).

Basler a d’abord formé deux CNN différents, l’un pour la classification des figurines Lego, l’autre pour la classification des panneaux de signalisation. Les CNN entraînés ne sont pas très volumineux avec seulement quelques mégaoctets et peuvent être transférés du cloud vers l’appareil de périphérie dans un laps de temps acceptable via une connexion à faible bande passante. Après avoir transféré la figurine Lego CNN, l’Edge Device a été en mesure de classer de manière fiable les figures et de rapporter le résultat au cloud avec de faibles besoins en bande passante et une faible latence. Pour "réoutiller" l’Edge Device afin de classer les panneaux de signalisation, il a suffi que le CNN de panneau de signalisation correspondant soit transmis depuis le cloud, de sorte que le capteur intelligent puisse ensuite détecter de manière fiable différents panneaux de signalisation.

Vers le logiciel pour la vision embarquéeLes avantages de la solution de vision embarquée en un coup d’œil

Faibles besoins en bande passante pour relier le capteur au cloud

Faible latence dans la réaction d’une application cloud à un événement de capteur

possibilité idéale pour la « télémaintenance » simultanée de plusieurs capteurs OTA (configuration du capteur, mise à jour du firmware ou par exemple téléchargement d’un nouveau CNN pour une nouvelle tâche de classification)